Il New York Times, impegnato in una causa che farà la storia di questa problematica per violazione del diritto d’autore da parte di Microsoft ed OpenAI che avrebbero addestrato i propri modelli di IA con miliardi di dati “rubati” al giornale, ha lasciato quasi completamente fuori dal suo paywall e, quindi, accessibile a tutti, un’inchiesta in stile “New York Times” e quindi completa di dati tecnici, pareri scientifici e molte fonti interne alle aziende, dalla quale si evincono in primo luogo le modalità sostanzialmente illecite con cui le aziende di IA si appropriano dei dati presenti in rete.

—

In un mondo dove l’intelligenza artificiale sta definendo i confini dell’innovazione tecnologica, le aziende leader del settore si stanno impegnando in una ricerca incessante di dati digitali, vitali per l’evoluzione delle loro tecnologie. Giganti come OpenAI, Google e Meta sono al centro di un dibattito acceso, poiché le loro strategie di acquisizione dati sollevano questioni legali e etiche, come emerge da un’indagine approfondita condotta dal New York Times dal titolo “Come i giganti della tecnologia smussano gli angoli per raccogliere i dati per l’A.I.” e dal sottotitolo ancora più esplicativo “OpenAI, Google e Meta hanno ignorato le politiche aziendali, alterato le proprie regole e discusso di aggirare le leggi sul copyright mentre cercavano informazioni online per addestrare i loro nuovi sistemi di intelligenza artificiale.”

Il NYT ha svolto questa indagine basandosi su pareri di scienziati, dati noti e pubblici, e una grande quantità di fonti interne alle aziende che restano, per ovvi motivi, anonime.

L’elemento centrale che emerge dall’analisi rappresenta forse la problematica più grande per tutti i sistemi di intelligenza artificiale: la carenza di dati per addestrare i modelli; carenza dovuta da un lato, alla effettiva voracità di questi sistemi i cui progressi sono direttamente collegati alla quantità di dati acquisiti in fase di addestramento, come dimostra la ricerca di Jared Kaplan della Johns Hopkins University, pubblicata nel gennaio 2020 che ha fornito un sostegno teorico a queste iniziative pratiche, suggerendo una correlazione diretta tra la quantità di dati di addestramento e l’efficacia dei modelli linguistici. Kaplan ha illustrato come i modelli di IA, simili agli studenti che apprendono da un maggior numero di libri, migliorano la loro precisione e capacità analitica con l’aumentare dei dati a loro disposizione.

L’articolo di Kaplan ha fornito una prospettiva innovativa, mostrando che queste “leggi di scala” nell’IA hanno una precisione paragonabile a quelle osservate in campi come l’astronomia o la fisica, un confronto che ha sorpreso molti nel settore. Questa rivelazione ha portato a un nuovo mantra nell’IA: “La scala è tutto ciò di cui hai bisogno”.

L’altro limite alla possibilità di acquisire i dati per l’addestramento dei modelli viene, come ben evidenziato nell’articolo del Times, dall’insieme di norme e restrizioni varie che vanno dal diritto d’autore alla privacy e che pongono ostacoli che però non sembrerebbero aver fermato le grandi aziende protagoniste di questa corsa sfrenata a divorare tutto.

Nel novembre 2020, OpenAI ha lanciato GPT-3, un modello formatosi su una quantità di dati senza precedenti nella storia dell’intelligenza artificiale: 300 miliardi di token. Questo progresso ha permesso a GPT-3 di eseguire compiti con una precisione eccezionale, creando post di blog, poesie e perfino programmando software.

Nello sviluppo del suo modello di punta, GPT-4, OpenAI si è confrontata con la carenza di testi in inglese di alta qualità, un ostacolo significativo. Per superare questa barriera, secondo fonti interne ad OpenAI, i ricercatori avrebbero utilizzato Whisper, un avanzato strumento di riconoscimento vocale capace di trasformare l’audio in testo, per convertire i video di YouTube in testo, nonostante le preoccupazioni interne relative alla potenziale violazione delle direttive della piattaforma.

Questa non è l’unica mossa audace nel settore: Meta ha contemplato l’acquisizione dell’editore Simon & Schuster, un piano che avrebbe potuto garantirle un flusso costante di contenuti letterari di qualità. Tra le strategie valutate da Meta ci sono la negoziazione di licenze e l’acquisizione di editori per accedere a un maggiore volume di contenuti.

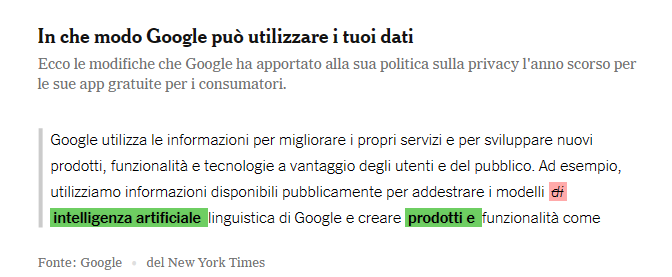

Google, d’altra parte, ha espanso i suoi orizzonti aggiornando i termini di servizio per integrare dati da Google Docs e Google Maps, una manovra strategica per arricchire le sue risorse informative per l’AI.

L’urgenza di acquisire dati è palpabile, con previsioni che indicano una possibile scarsità di dati di alta qualità disponibili online entro il 2026. Questa situazione spinge le aziende a un consumo di dati senza precedenti, spesso al limite delle regolamentazioni vigenti. In questo contesto frenetico, figure come Sy Damle di Andreessen Horowitz evidenziano che l’addestramento su vasti insiemi di dati senza vincoli di licenza potrebbe essere l’unica via percorribile per mantenere il passo dell’innovazione.

DeepMind, affiliato a Google, ha seguito pedissequamente queste indicazioni, spingendo i limiti con il modello Chinchilla, addestrato su 1,4 trilioni di token. Ma questa cifra è stata presto superata da altre innovazioni, come il modello Skywork cinese, addestrato su 3,2 trilioni di token, e PaLM 2 di Google, che ha sfiorato i 3,6 trilioni di token.

Tuttavia, questa frenetica corsa ai dati non è priva di complicazioni. L’uso massiccio di opere creative per addestrare questi modelli ha sollevato questioni legali, come evidenziato dalle azioni legali intraprese dal Times contro OpenAI e Microsoft per l’utilizzo di contenuti senza permesso. Questa situazione ha spinto oltre 10.000 entità a esprimere, negli Stati Uniti, le loro preoccupazioni al Copyright Office, avviando un ampio dibattito sui diritti d’autore nell’era digitale.

Le aziende di spicco nel settore, tra cui Google e Meta, hanno dichiarato di utilizzare dati acquisiti legalmente, con Google che sottolinea l’uso di contenuti di YouTube secondo accordi con i creatori e Meta che vanta investimenti nell’intelligenza artificiale, utilizzando immagini e video da Instagram e Facebook.

Parallelamente, Google naviga in acque turbolente, confrontandosi con dilemmi legali riguardanti l’utilizzo dei dati di YouTube. Sebbene la politica interna di Google permetta l’uso dei dati per migliorare i servizi interni, rimane ambiguo se tali dati possano essere utilizzati per sviluppare servizi commerciali esterni. In questo contesto, Google ha valutato l’espansione dell’utilizzo dei dati degli utenti, esplorando l’integrazione di informazioni da Google Docs e altre app nelle iniziative di IA.

Nel tentativo di superare la penuria di dati, Altman ha proposto un approccio pionieristico: addestrare l’IA su dati sintetici generati dall’intelligenza artificiale stessa. Questa metodologia potrebbe offrire una soluzione alla dipendenza da dati protetti da copyright, benché presenti sfide tecniche significative, come il rischio di feedback loop che possono rinforzare errori e limitazioni nei modelli di IA.